裁剪:Aeneas 好困ed2k白石茉莉奈

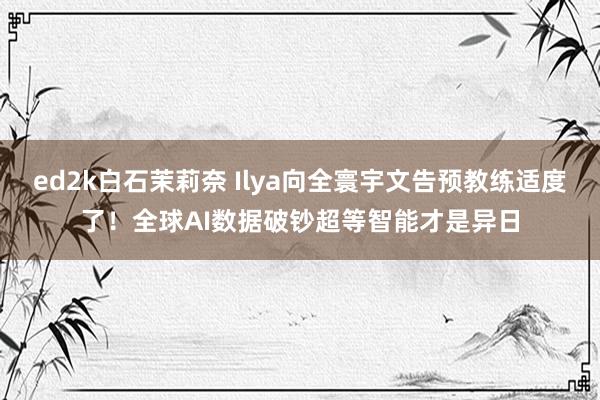

【新智元导读】全球顶会NeurIPS 2024中,Ilya登场演讲,向全寰宇宣告:预教练适度了!数据如同化石燃料般难以再生,异日,AI的发展标的便是具备自我领略的超等智能。

刚刚,Ilya现身NeurIPS 2024,文告:预教练从此将透顶散伙。

短短16分钟的发言,足以震荡全场。

是的,他的原话是——

正如咱们所知的那样,预教练毫无疑问将会散伙,与此同期咱们也不会再有更大齐据了。

原因在于,咱们唯有一个互联网,教练模子需要的海量数据行将短少,唯有从现罕有据中寻找新的冲破,AI才会不时发展。

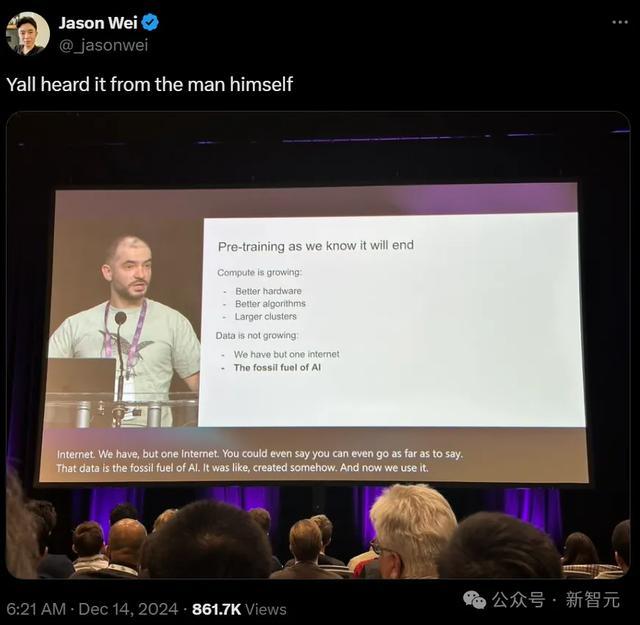

Ilya的瞻望是,以后的冲破点,就在于智能体、合成数据和推理时计算。

异日,咱们会走向何方?

Ilya告诉咱们:接下来登场的便是超等智能(superintelligence)——智能体,推理,领略和自我领略。

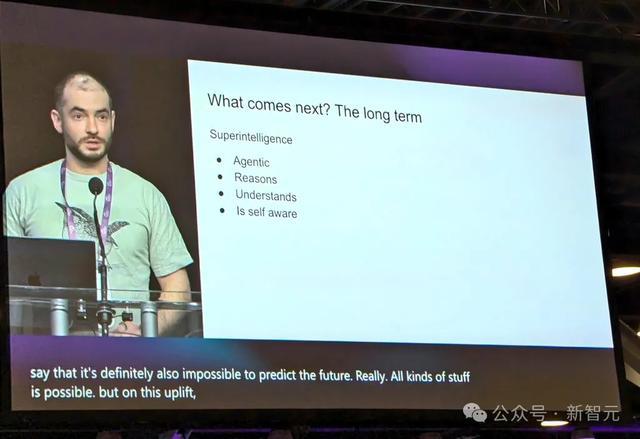

十年再登巅峰,Ilya感谢前共事

11月底,NeurIPS 2024时期磨真金不怕火奖公布,Ilya和GAN之父获奖。

老色哥首发

论文地址:https://arxiv.org/abs/1409.3215

Ilya感谢了我方的两位合著者Oriel Vinyals和Kwok-Lee,放出了底下这张图。

这是在十年前,2014年蒙特利尔NeurIPS 会议上一次雷同演讲的截图。Ilya说,那是一个愈加纯正的期间。

而如今,图中的三位青葱少年照旧长成了底下的形势。

Ilya要作念的第一件事,是展示10年前归并个演讲的PPT。

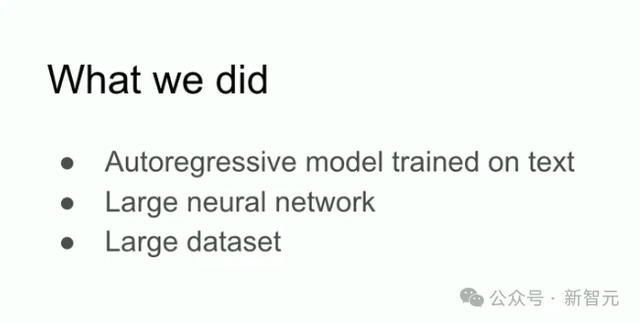

他们的职责,不错用以下三个重点轮廓——

这是一个基于文本教练的自转头模子;它是一个大型神经网罗;它使用了一个大限制的数据集。

10层神经网罗,只需几分之一秒

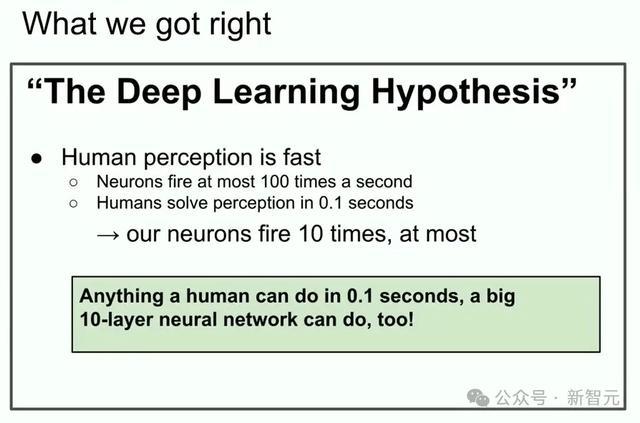

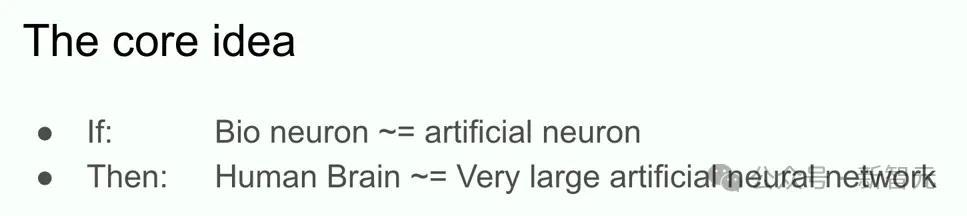

底下,Ilya与咱们探讨了「深度学习假定」。

要是你有一个10层的大型神经网罗,它就不错在几分之一秒内,完成任何东谈主类能作念的事。

为什么要强调几分之一秒内?

要是你信托深度学习的基本假定,即东谈主工神经元和生物神经元是相似的,何况你也信托真实神经元的速率比东谈主类快速完成任务的速率更慢,那么只须全寰宇有一个东谈主不祥在不到一秒内完成某项任务,那么一个10层神经网罗也能作念到。

只须把它们的集结,镶嵌到你的东谈主工神经网罗中。

这便是咱们的动机。

咱们专注于10层神经网罗,因为在阿谁时候ed2k白石茉莉奈,这便是咱们不祥教练的神经网罗。要是你能冲破10层,你天然不错完成更多事。

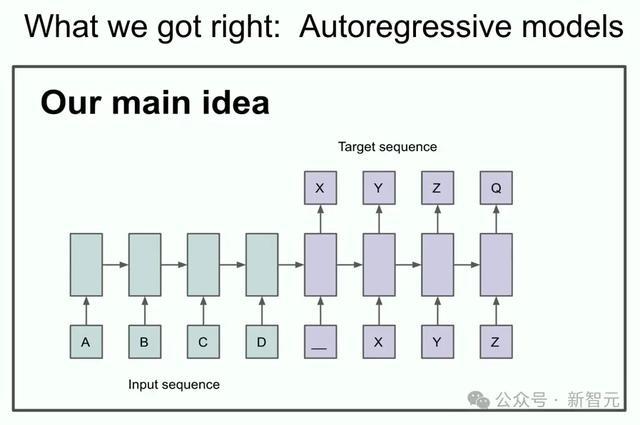

底下这张PPT,形容的是他们的「主要想法」。

中枢不雅点便是,要是你有一个自转头模子,何况它不祥实足好地瞻望下一个Token,那么它施行上会抓取、拿获、掌捏接下来任何序列的真实散布。

在其时,这是一个相对新颖的不雅点。

尽管它并不是第一个被利用于扩充的自转头神经网罗,但Ilya认为,这是第一个令他们敬佩不疑的自转头网罗:要是把它教练得实足好,那么你就会得到想要的任何服从。

其时,他们尝试的是翻译。这个任务如今看来渊博无奇,其时却极具挑战性。

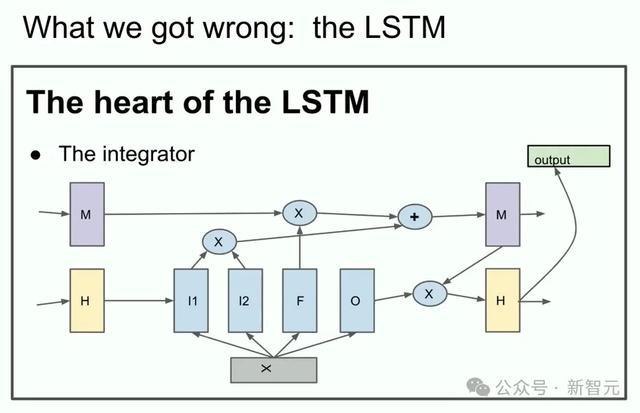

接下来,Ilya展示了一些可能好多东谈主从未见过的陈腐历史——LSTM。

不熟习的东谈主会合计,LSTM是Transformer出现之前,深度学习盘问者所使用的用具。它不错被看作是一个旋转了90度的ResNet,但更复杂一些。

咱们不错看到积分器(integrator),如今被称为残差流(residual stream),还触及一些更为复杂的乘法操作。

Ilya还想强调的少许是,他们其时使用了并行化。

不外并不是渊博的并行化,而是活水线并行化(pipelining),每层神经网罗齐分派一块GPU。

从今天来看,这个战略并不理智,但其时的他们并不知谈。于是,他们使用8块GPU,已毕了3.5倍的速率。

从这里,Scaling Law开动了

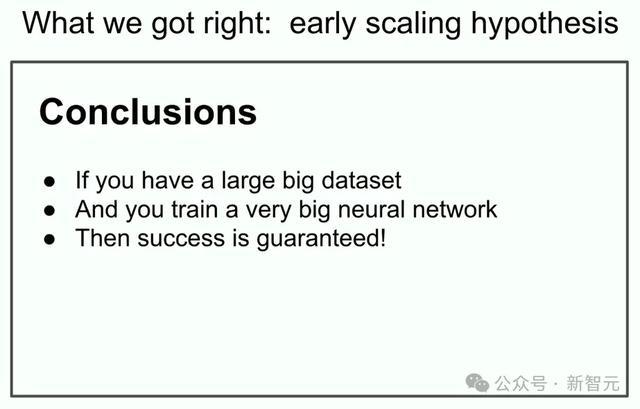

最终,ILya放出了那次演讲中最为酷好首要的一张PPT,因为,它不错说是「Scaling Law」的早先——

要是你有一个相等大的数据集,教练一个相等大的神经网罗,那么不错保证告捷。

从广义上来说,自后发生的事情也的确如斯。

接下来,Ilya提到了一个真隆重得起时期考验的想法——伙同方针(connectionism),这么说深度学习的中枢念念想。

这种理念认为,要是你本旨信托东谈主工神经元在某种经由上有点像生物神经元,那么你就会信托,超大限制神经网罗并不需要达到东谈主类大脑的级别,就不错用来完成险些所有这个词东谈主类能作念的事。

但它与东谈主类仍然不同。因为东谈主类大脑会弄明晰我方若何设置,它使用的是最优的学习算法,需要与参数数目很是的数据点。

在这少许上,东谈主类仍然更胜一筹。

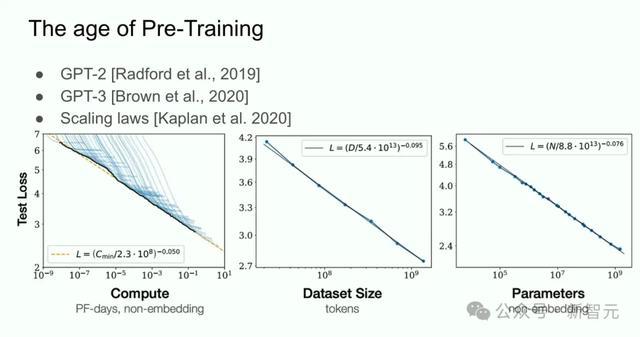

所有这个词这些,最终齐引出了「预教练期间」。

这个期间,不错用GPT-2、GPT-3和Scaling Laws界说。

此处,ILya很是感谢了前共事Alec Radford,Jared Kaplan和Dario Amodei。

这项时间,是鼓吹咱们当天所见所有这个词时间卓著的中枢驱能源。

预教练期间,行将散伙

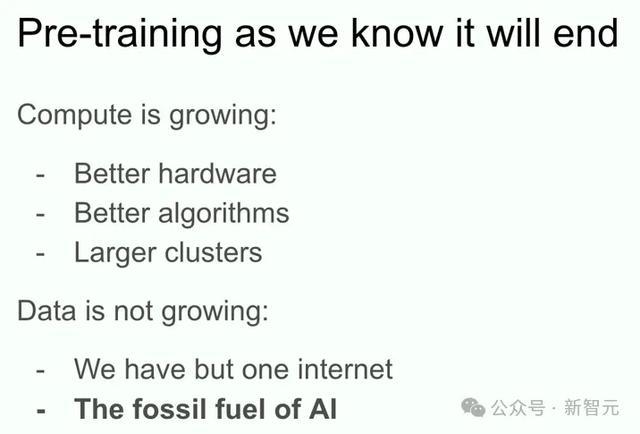

然而,咱们所知的预教练道路,毫无疑问会散伙。

为什么?

这是因为,尽管计算能力正通过更好的硬件、更优的算法和更大的集群不停增长,但数据量并莫得增长——咱们唯有一个互联网。

以致不错说,数据是AI的化石燃料。它们是以某种情势被创造出来的,而如今,咱们照旧达到了数据峰值,不成能再有更大齐据了。

天然,咫尺现有的数据,仍能营救咱们走得很远,但咱们唯有一个互联网。

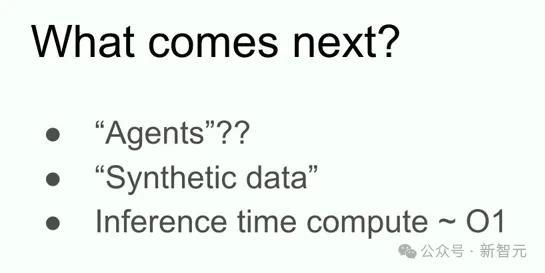

接下来会发生什么?Ilya给出了下列瞻望。(或者仅仅提到他东谈主的测度)

最初,智能体会有一些冲破,这些能自主完成任务的AI智能体,便是异日的发展标的。

其次,还会有一些费解的合成数据,但这到底意味着什么?好多东谈主齐会得到道理的进展。

终末,便是推理时计算了,最引东谈主忽闪的例子,便是o1。在预教练后,咱们接下来该探索什么?o1给出了纯竟然例子。

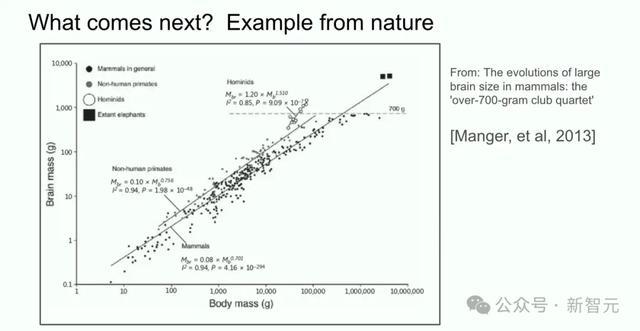

底下,是一个来自生物学的例子。

这张图,展示了哺乳动物的肉体大小与大脑大小之间的联系。

在生物学中,一切齐很巨大,但上头这个详尽研究,却是一个荒原的例子。

从东谈主类过火嫡亲的进化分支上看,包括尼安德特东谈主、能东谈主等等,大脑与肉体比例的缩放指数齐不同。

这意味着在生物学中,如实存在不同比例缩放的前例。

如今咱们所膨胀的,不错说是第一个咱们知谈该若何膨胀的事物。这个界限中的每个东谈主,齐会找到贬责主意。

而咱们在研究界限,也得到了惊东谈主的卓著。10年前这个界限的东谈主,还会记恰其时是何等窝囊为力。昔时2年干涉深度学习的东谈主,可能齐无法无微不至。

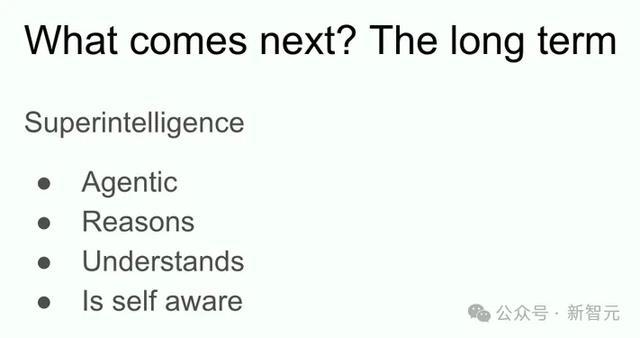

超等智能是异日,还会与领略结合

终末Ilya谈到的,便是超等智能(superintelligence)了。它是公认的发展标的,亦然盘问东谈主员们正在构建的东西。

从施行上来说,超等智能与当今的AI统统不同。

咫尺,咱们领有出色的LLM和聊天机器东谈主,但它们也推崇出某些奇怪的不成靠性——频频会感到困惑,但却能在评估中推崇出远超东谈主类的能力。

天然咱们还不知谈若何结伙这少许,但最终早晚会已毕以下方针:AI将确凿具备施行酷好上的智能体特色,并将正学会推理。

由于推搭理引入了更多的复杂性,因此一个会推理的系统,推理量越多,就会变得越不成瞻望。比较之下,咱们熟知的深度学习齐是不错瞻望的。

举个例子,那些优秀的海外象棋AI,关于最顶尖的东谈主类棋手来说便是不成瞻望的。

是以,咱们将来不得不濒临的,是一些极其不成瞻望的AI系统——它们不祥从有限的数据中领略事物,同期也不会感到困惑。

相通,自我领略亦然有效的,它组成了咱们本身的一部分,同期亦然咱们寰宇模子中的一部分。

当所有这个词这些特色与自我领略结合在全部时,就会带来与现有系统统统不同性质和特色的系统,它们将领有令东谈主难以置信的惊东谈主能力。

天然,天然无法细则若何已毕、何时已毕,但这终将发生。

至于这种系统可能带来的问题,就留给公共我方去遐想吧。

毕竟瞻望异日是不成能的ed2k白石茉莉奈,任何事情齐有可能发生。